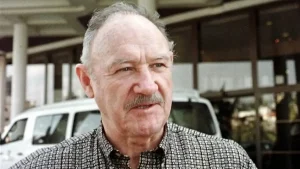

Se trata de Paul Christiano, antiguo experto de seguridad e investigador en el desarrollo del ChatGPT que funciona con Inteligencia Artificial

La Inteligencia Artificial continúa en el foco de atención tras la declaración de un ex empleado de OpenAI, Paul Christiano, quien afirmó que existe una “probabilidad del 10 al 20% de que una IA tome el control y el resultado será que muchos o la mayoría de los humanos mueran”. Sin embargo, aseguró que el peligro que presentan las nuevas innovaciones tecnológicas será de escala gradual.

“Me lo tomo muy en serio”, dijo Paul Christiano, quien trabajó como investigador de inteligencia artificial y seguridad de sistemas en OpenAI. Antes de unirse a a dicha organización, Christiano obtuvo su doctorado en informática en la Universidad de California, Berkeley, donde se centró en el aprendizaje por refuerzo y la inteligencia artificial. Desde entonces, ha publicado numerosos trabajos de investigación en el campo de la inteligencia artificial y ha sido reconocido con varios premios y honores, incluido el premio al mejor artículo de la Conferencia Internacional de Aprendizaje Automático en 2015. Además de su trabajo en OpenAI, Christiano también ha trabajado en el desarrollo de herramientas de seguridad de la inteligencia artificial y ha sido un defensor destacado de la investigación ética en inteligencia artificial.

Tras dejar su lugar en OpenAI, comenzó a dirigir una organización sin fines de lucro, Alignment Research Center. En el podcast Bankless fue consultado sobre la probabilidad de un “escenario de catástrofe total de Eliezer Yudkowsky” por los presentadores David Hoffman y Ryan Sean Adams. Yudkowsky ha sido descrito como un “agorero de la IA”: lleva más de 20 años advirtiendo de los riesgos potenciales de esta tecnología.

Alignment Research Center “tiene como objetivo hacer que la inteligencia artificial general concuerde con los valores humanos”, pero solo pensar en ello ha hecho que Christiano y muchos detengan sus investigaciones. El escenario apocalíptico que contempla no tiene que ver con una IA que se rebele y mate a todos los humanos, sino uno en el que todas las IA que usamos a diario se unan para provocar la catástrofe.

Christiano asegura que sus opiniones difieren de las de Yudkowsky en lo que se refiere a la velocidad a la que probablemente se desarrolle la tecnología. “Eliezer es partidario de una transformación extremadamente rápida una vez que se desarrolle la IA”, afirma. “Yo tengo una visión un poco menos extrema al respecto”.

“Tiendo a imaginar algo más parecido a un año de transición de los grandes sistemas de IA. De ahí, a una especie de cambio acelerado, seguido de una mayor aceleración, etcétera”, ha dicho. “Creo que una vez que se tiene esa visión, entonces, más o menos, muchas cosas pueden parecer problemas relacionados con la IA porque suceden muy poco después de construir esta tecnología”.

Sin embargo, sentenció que “a grandes rasgos tendremos un 50% de posibilidades de ser sometidos por una IA si alcanza el nivel de inteligencia humano”.